作者: 安德鲁·派珀 沙德·威尔蒙 默罕默德·车力特 陈大龙(译) 赵薇(校);转自:公众号 DH数字人文

概念与实践

安德鲁·派珀 / 加拿大麦吉尔大学语言、文学与文化系

沙德·威尔蒙 / 美国弗吉尼亚大学德语语言与文学系

默罕默德·车力特 / 加拿大魁北克大学高等技术研究院

陈大龙(译) / 浙江大学国际联合学院

赵薇(校) / 中国社会科学院文学所

————————————

摘要:“文档图像分析”(DIA)是一种具有程序性、转换性和偶然性的知识,并且在本质上包括出错的可能。在对历史档案的研究中,这种分析方法吸收了书籍史和书志学的传统以及媒介间性理论,不再以文本为中心,而是以整个“页面图像”为分析对象,不再以还原原初的理想版本为目标,而是要通过构建和分析新的页面表征,更好地了解过去的社会实践。在实际操作中,文档图像分析发展了一套包括归一化、分割、特征选择、机器训练、预测和验证在内的程序化的方法,以分析页面不同的视觉特征。文章将这一套方法用于分析脚注在18世纪文艺、历史、宗教、科学四个领域的文档以及18至19世纪欧洲五国的科学论文集中的使用,展现了学科格局的新时代。这表明,“文档图像分析”是一种很有价值的历史研究工具。

关键词:页面图像 文档图像分析 书籍史 书志学 知识史

————————————

1991年9月30日,逾200名研究人员集聚在法国圣马洛(Saint Malo),召开了史上第一次关于“文档分析与识别”的大会。[1]这次会议汇集了来自世界各地的研究人员。在之前的大约十年间,他们都在慢慢改变自己处理数字化页面的机器理解问题的模式。长期以来“光学字符识别”(Optical Character Recognition, OCR)领域的基础是“字符”和“识别”。而这些研究者不再从这个角度来思考问题了,而是逐渐转向一个更具整体性和形式性的理解方式:理解整个页面图像。在这个被称为“文档图像分析”(Document Image Analysis, DIA)的领域,研究人员摒弃了字母或者文本是图书页面的最终所指这一普遍假设,转而关注页面异质性的视觉特征上,也即他们所称的“页面图像”(the page image)。乔治·纳吉(George Nagy)在该领域二十年研究概况中写到:“文档图像分析”是“恢复由纸质材料扫描得来或由计算机所生成数字图像的符号结构的理论和实践。”[2]DIA研究者把页面图像转化成了分析的对象。

在摆脱以文本为中心的页面理解方式的过程中,文档图像分析研究为思考图书页面提供了一种重要的新思路。这种思路不同于传统以计算方法进行文化研究的方式,而是深深植根于书籍史、书志学和文本研究领域。无论是在“自然语言处理”(NLP)、“光学字符识别”(OCR),还是在“文本挖掘”的幌子下,以计算方法处理页面的方式一直深受以文本为中心的心态影响,把页面图像作为实现目的的工具(往往还是不完美的),把页面图像当作一个途经的对象,而非当作本身潜在的具有意义的东西来研究。与此同时,从人脸识别到报刊插图分析,快速发展的“图像分析”领域,也在很大程度上保持了文本—图像的分隔。这种分隔长期支配着文化研究。无论是独立的(stand-alone)对象,还是准文本的“插图”,图像都被视作独立于文本的。于是,新出现的研究过去的计算方法依然保留了长期以来学科上的分隔,并在此过程中强化了在文档中文本性是研究的理想对象的观念。

以文本为中心的文档计算研究方法,尽管有很多积极的学术优势,但也可能限制了我们对过去的思考方式。比如,我们关于过去的“机器可读”(与“机器可观察”相对)的信息覆盖范围的认知,在时间和空间上,都有很大偏颇。目前任何表达方式的、来自数字化页面图像的可用文本数据,只能可靠地追溯到19世纪,还有两千多年的人类书写被忽略掉了。类似地,尽管每天都有改进,但是OCR技术依然偏爱非常特别的基于罗马字的字体,于是像中国的木版印刷这样非西方的印刷传统,还有中世纪手写本这样的非印刷传统,以及德国花体字这样区域性的不拘一格的印刷传统等,都被忽略了。

第二,很多计算方法与技术以文本为中心,这掩盖了技术中介的层次,而正是这些技术中介首先产生并提供了数字文档。瑞恩·柯代尔(Ryan Cordell)认为,我们需要更多地思考,每一个数字化版本或历史版本的OCR版本是如何成为该文本的另一个“背景”,被最初的印刷品(或手稿)所处的一系列类似的历史条件所约束的。[3]就像特定的印刷社、出版社以及管理印刷版本外观和质量的一系列做法一样,被光学字符识别的文本也类似地受制于特定的机器或者制度环境以及人的校正、排版(“清理”[cleaning])实践。这就带来了不同的产出。类似地,马修·科尔什鲍姆(Matthew Kirschenbaum)也大力主张那些本身就是数字创建的文档的物质性,因为它们也受制于计算机硬件。[4]而我们也在别处说过,数字化的页面图像不应当被看作是普遍的、非实体的(disembodied)、可以在任何地方为任何人所用的;相反,它们应该被当作物理对象,具有可以层累地使用、流通和操作的历史。[5]页面图像是一个做事情的东西(a thing that does things)。

对最近一代的书志学家和书籍史学家而言,围绕着页面的视觉和物理特质进行这样的重新定位并不奇怪。邦妮·麦(Bonnie Mak)的书《页面如何重要》(How the Page Matters)是一个关于页面视觉维度的研究,正如克里斯多夫·文德盖特(Chirstoph Windgätter)的《媒介转换》研究是基于浪漫主义时代书写的一种新的视觉“渠道化(channelization),而这种“渠道化”对其后的阅读和书写实践产生了深远的影响。[6]加勒特·斯图尔特(Garrett Stewart)的《阅读之貌》,强调了凸版书写(writing in relief)的视觉特质:这部具有开创性的图像历史,是关于视觉艺术中书写的表征的,在其中我们看到了艺术家和观看者承认书写和阅读具有挑战性的视觉性。[7]

这些研究借鉴了一个重要的哲学传统,即抛开了声音—文字这个方向,而转向更加关注视觉的方向,以此重塑了关于书写的历史。沃尔特·翁(Walter Ong)在其颇具影响的著作中,把书写当作脱离口述的运动,而与其不同的是,像西比尔·克莱默(Sybille Krämer)这样的哲学家则试图引起人们对书写的视觉演变及其认识论后果的关注。[8]正如玛拉·米尔斯(Mara Mills)展示的那样,当我们这样做时,就开始关注阅读、视觉障碍与媒介技术的演变之间的整体关系。[9]类似地,思考书写的视觉特质,对人类阅读与认知障碍和发展的神经学研究来说,也已成为不可或缺的组成部分。[10]

因此,DIA计算框架的很多重要假设,跟塑造了书籍史领域及其邻近相关的其他人文学科,甚至一些自然科学的假设,是相同的。然而,尽管保罗·费夫(Paul Fyfe)和娜塔莉·休斯顿(Natalie Houston)在DIA上早做出了重要的贡献,但是DIA及其方法和见解在此领域以外依然鲜有人知,甚至在文化的计算研究领域内也很少为人所用。[11]这篇文章有两个目标。第一,我们想向书籍史学者介绍一些计算方法,这些方法可以运用到数字领域的图书研究上去。用计算方法进行文化研究的价值就在于:在要做出关于过去的推论时,这些方法可以显著地扩大所考虑的证据的规模。但是,核心的挑战是,对于不熟悉这些方法的学者来说,计算方法仍然是难以理解的。为了跨越这个界限并(在所有方面)抵制那种把计算方法与(据称)更人文的方法对立起来的趋势,我们要描述DIA的技术和认识论理想,还要强调其与那些书籍史、书志学和语文学更典型相关的理想、方法和前提之间的连贯性与分歧。我们认为,DIA在一些重要的方面上是这些书志学和语文学传统中未被承认的分枝。通过详细描述DIA并指出它的一些书志学和语文学基础,我们希望帮更多的图书与文化历史学家明确对过去进行计算研究的一些优势与局限。同时,我们也希望使已经在使用计算方法对过去进行研究的学者确信,DIA对他们大有裨益。特别是DIA可以帮助他们围绕对文档的视觉研究重新定位自己的思维,因为正如我们将展示的那样,这种思考模式其实在书籍史领域有着经久不衰的传统。正如其他人已经论述的,将书籍史的前提插入到对过去的数字研究中,将会收获颇丰。

为了解决这个问题,我们利用了自己多年来对科学注释(scientific notation)历史的研究,这被称为“知识的可见性”(The Visibility of Knowledge)。通过整合书籍史、科学史和文档图像分析等领域,我们对理解图形化手段运用的发展产生了兴趣。17世纪以来,图形化手段的运用一直伴随着科学知识的生产,并且在很多方面为其提供了支持。像亚德里安·约翰斯(Adrian Johns)、伊丽莎白·爱因斯坦(Elizabeth Eisenstein)、安·布莱尔(Ann Blair)等一系列学者所表明的那样,17世纪出现的对科学知识的认识论要求是与印刷媒介密切相关的。[12]新知识的创造不仅仅是实验和天赋的洞察力的功能,而且是以印刷形式呈现的知识组织与传播的功能,而这依赖于建立新的、而且通常是视觉的交流协议。随着科学知识的术语与方法变得愈发复杂,像使用脚注、表格(tables)、图表(diagrams)和参考图表(figures)等图形化手段的运用,在建立证据规范方面就愈发不可或缺。脚注在视觉上将页面分为了两个部分,一个指向文本外世界中的实验和观察(正文部分),另一个则指向更多的文本,从而创造了新的虚拟的群落。[13]表格使形式迥异的信息在二维空间的形式上进行对话(这反映了页面自身的几何倾向)。图表则通过新的视觉综合,呈现出复杂的实验或概念过程。[14]模仿性插图(mimetic illustration)或者“参考图表”(figures)将读者(因而也还有科学家同行)引导到共通的对象和观察方法上去。[15]这些视觉元素并非仅是科学知识的补充或者科普化。它们帮助构建了一种独特的视觉语言。对于什么可以继续被算作科学知识,这种语言在其发现、分析和辩护中都成为了关键组成部分。

直到最近,科学史学家一般还是依靠人工筛选文档。甚至连像洛兰·达斯顿(Lorraine Daston)和彼得·加里森(Peter Galison)对“客观性”(objectivity)的研究这样的大型综合研究,也都受到研究者个人的时间和偏好的独特限制。[16]诚然,对书面纪录的过去进行这种细密的分析,产生过重要的见解。但是,计算方法不仅使我们得以对过去进行更大规模、也可能更具代表性的观察,还使我们得以收集到更多内容,在此基础上检验我们的假设。计算方法使我们能够检验关于过去的典范性的主张,而不是手工选择例子来证实我们先在相信的东西。计算方法可以帮助我们更好地对过去进行采样,并使我们能够更好地说明自己研究中的错误和潜在的偏误。

当然,“规模”(scale)在过去几年中已经成为塑造人文学科的关键概念之一了。[17]但我们借助于规模,并不应被视为滑向透明性的修辞(the rhetoric of transparency)。无论这种修辞的支持者还是批评者,都常借助于规模,就是数据越多越好。随着历史学家和人文学科各个领域的学者越来越多地使用计算方法,并与来自更专注于计算领域的同事合作,像反思书志学条件一样严格地对知识的计算条件进行反思,就变得很关键。几十年来,书籍史学家已经教会人文学科各个领域的学者,如何更好地处理知识的印刷条件和印刷档案中证据的状况。而在印刷文档被数字修复的条件下,学术知识认识论的理想和实践正发生着变化。但是,如何将这种理想和实践理论化,在这方面我们才刚刚起步。那么,在讨论知识的可见性时,我们就会以这两种不同但是相关的方式使用这个概念:一是指我们研究的对象和我们借以研究它的方法,二是知识如何通过看而形成,以及我们如何通过知识来看。

将文档图像分析引入科学传播史,我们主要的目标之一就是强调“页面图像”是历史分析中的核心单位。无论在我们长期项目的进行过程中,可能有什么具体的发现,我们这篇文章更紧要的目标都是在双重意义上开始把页面图像作为中介对象严肃对待:第一层意义是把页面作为一种图像(as an image),也即,首先是从视觉上关注页面,而非将其看作文本性的对象或者仅仅是所有特质中带有图像性质;第二层意义是把页面图像视作页面的图像(as an image of a page),也即,将其视作知识的中介对象而非其自身(the thing itself)。通过把书籍史、重要的书志学见解与DIA的方法论见解相结合,我们希望把学术注意力吸引到这样的方面上来:(在开始读或者解释文档之前)我们所看到的,首先是一个不存在的人工制品的表征。然后,在最普遍的意义上,这篇文章将我们导向在数字环境中书志学知识的分层中介研究上。通过这样做,我们希望提供另一种可能的立场,来了解我们印刷所展现的历史。

一、以不同的视角看页面:从书志学到机器学习

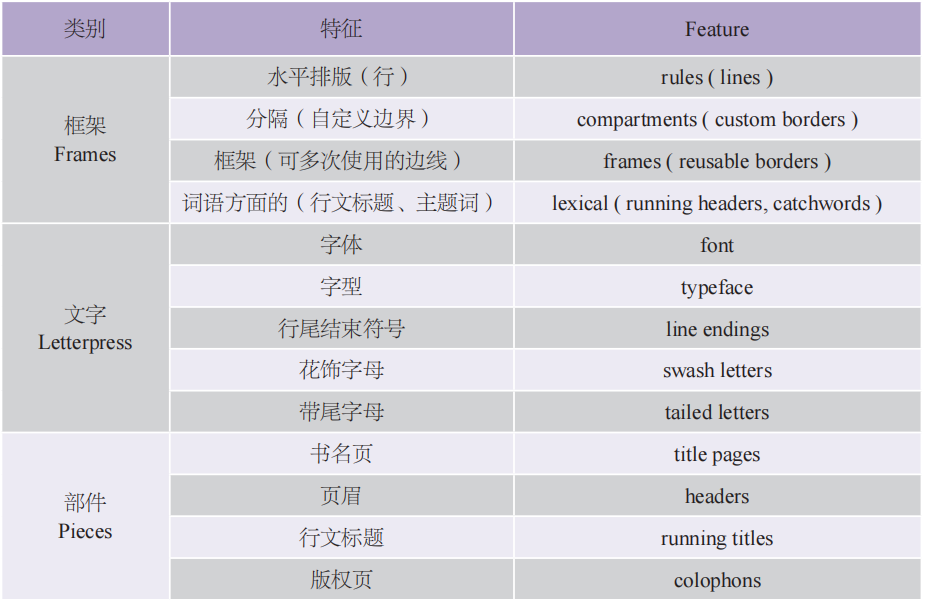

长期以来,书志学家和书籍史学家一直在思考页面的视觉维度。根据菲利普·加斯凯尔(Philip Gaskell)的《新书志学导论》,页面的视觉特质有三个主要维度(见表1)。[18]框架指的是边框、行和其他在视觉上分割页面的要素的运用,还包括像行文标题(running headers)和主题词(catchwords)这样的词语方面的特征。活字印刷(letterpress)部分考虑的是与字母的视觉特质相关的各种问题,从字型到水平排版质量,再到特殊的字母,比如花饰字母(swash)、带尾字母(tailed letters)。而部件(pieces)则包括像章节标题或页眉(headpiece)、书名页和版权页等方面,在这些方面中,非词汇性的视觉元素已经被用于分段装饰(decorate or ornament)页面。

表1 加斯凯尔总结的页面视觉维度

在书志学领域中,最初对视觉特征的强调,很多都明确地以装饰性原则为指导(加斯凯尔给他的那一章所定的题目正是“装饰与插图”)。相对于解释单个作品特定表征的产生历史,视觉性只被视为对这一更核心问题的装饰性补充。很能说明问题的是,对页面视觉维度的研究,在加斯凯尔这本手册中,只占据了很小的一部分(在400页的书中只有大约6页)。这说明,相对于图书研究的其他问题,视觉问题是边缘性的。

除了书志学上这种对装饰性页面的倾向以外,当然还有另一种长期存在的对图书插图历史更具艺术史意义的研究。约翰·哈桑(John Harthan)、戈登·雷(Gordon Ray)、阿图尔·吕曼(Arthur Rümann)、和特奥多·库奇曼(Theodor Kutschmann)奠基性的著作,在不同的技术框架下,重构了图书插图的不同时期和技术。[19]在这种情况下,视觉的东西更多地是被视作热拉尔·热奈特(Gerard Genette)所称的“准文本”(paratext),它与真正的文本相邻却又与之区别开来。视觉的东西并不是与页面相联系,而是被当作一种独特的图像实践,具有自己的一套惯例、谱系和践行者。

在过去的十年里出现更多的最新研究是以“媒介间性”理论(theory of intermediality)为基础的。与以往不同的是,这种研究强调的是图书的文本和视觉特征相互作用的方式,而结果反过来又塑造了读者与书籍的互动。这项工作的目的是超越文本和图像之间的二元对立,文本如何像图像似的发挥着作用,而图像又是如何能够像文本一样被“阅读”。在这一传统中,视觉上的东西被视为书籍史不可或缺的组成部分,而不再是被视为文本的附带物——无论是作为一种装饰形式,还是作为文本之外享有特殊地位的东西。

我们认为,文档图像分析实际上以不同的方式从三个传统中都暗中汲取了营养。无论这种汲取是不明显的,还是未被承认的,要理解计算方法对于研究数字文档的人文学者的局限与优势,关键都在于理解这种互补性。[20]一方面,与许多数据驱动的研究一样,DIA方法是基于归一化(normalization)的理念的。在分析页面图像的特征之前,DIA研究者会采取一系列步骤,目的是将成像处理过程中的影响跟原文档的视觉特质分离开来。

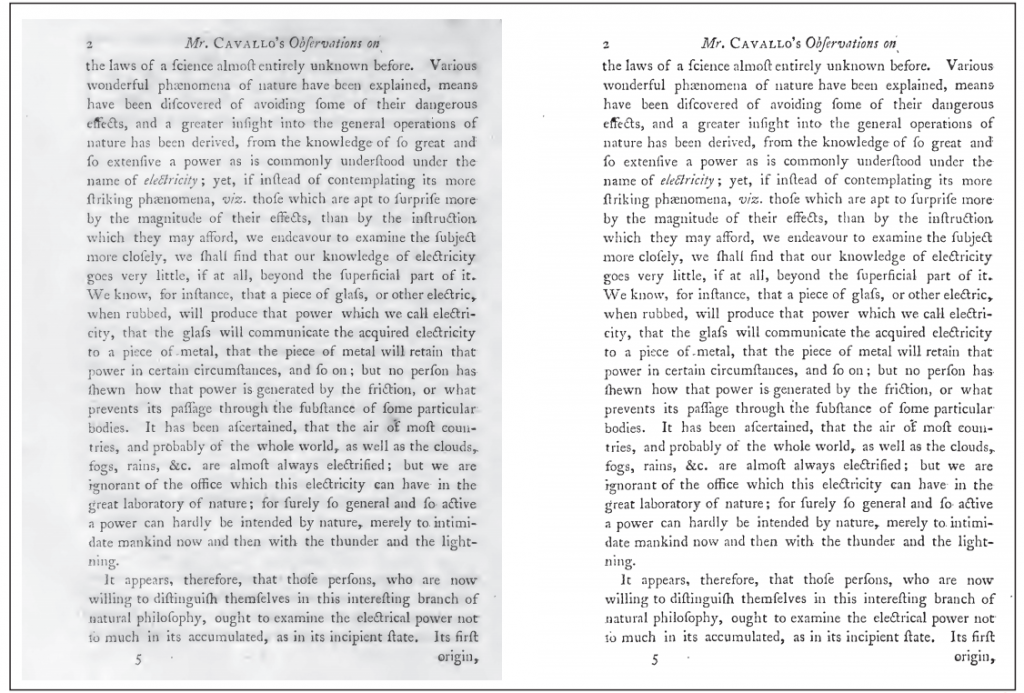

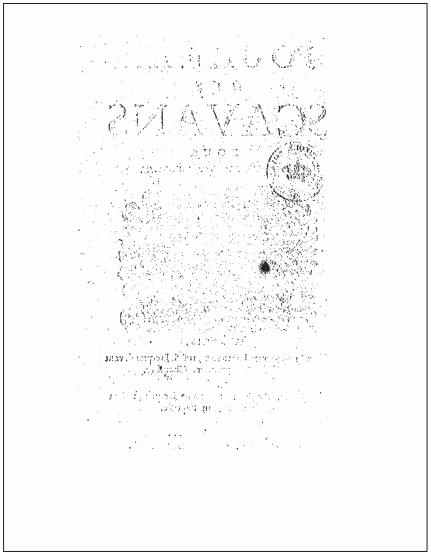

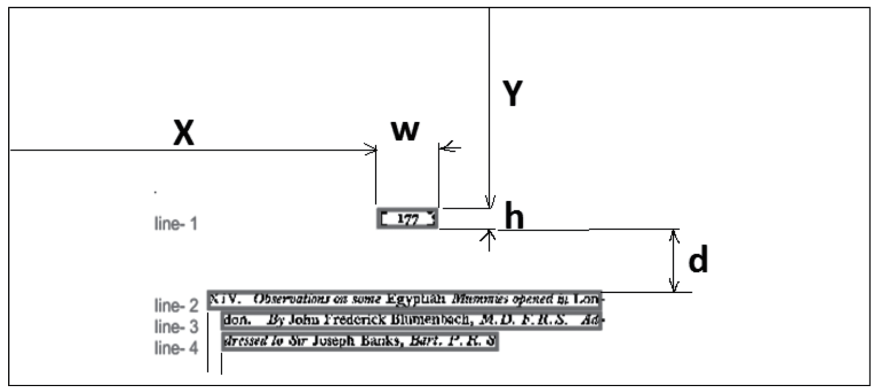

例如,这个过程中最重要的步骤之一就是二值化(binarization)。这被用于区分DIA研究者所说的页面图像的前景与背景(见图1)。与二值化过程有关的页面特质,可能包括由于老化而导致的颜色不连续(见图1左)或者墨水的渗透(不管是本页的还是相邻页面之间的)(见图2)。图像化的过程会带来一些痕迹,这些痕迹也是与这一步有关的,比如数字化的对象是缩微胶片而非真正的图书时,灰尘与刮痕的存在。另一个关键步骤被称为纠偏(deskewing),这个步骤会校正由于扫描仪与原页面不完全对齐而带来的扭曲(见图3)。纠偏通常会涉及创建页面上每一行的水平投影的直方图。想象一下,在页面上垂直移动水平标尺,每次移动一个像素。根据这一行黑色像素多少,在右边对应创建直方柱,黑色像素越多,直方柱就会越高。很短的直方柱(或者没有直方柱)就表示没有黑色的像素(也就是空白)。直方柱很高就意味着黑色像素很多,也就是说字母排布比较稠密。页面图像越倾斜,直方图就会越平坦,因为当字延伸或者弯曲时,它看上去更宽(见图3左)。反之,直方图形状越尖,区分度越大,就意味着页面越平均(见图3右)。

来源:生物多样性遗产图书馆(The Biodiversity Heritage Library)

来源:法国国家图书馆(Bibliothèque Nationale de France)

来源:“十八世纪作品在线”(Eighteen-Century Collections Online)

像二值化或者纠偏这样的步骤强调两种信息之间的区别:一种是页面上研究者相信是重要的或者有意表达的信息,另一种是在图像化处理过程中意外引入的信息或者背景信息(计算机科学家或称之为“噪音”)。书籍史学者会在这种语言表达中立即发现对书志学者的回应。书志学者早已对“有意为之的”痕迹和“意外产生的”痕迹进行了区别。意外产生的痕迹是页面上的错误或者非同寻常的特殊点(peculiarities),它们模糊了页面“真正的”或者有意要表达的信息。在这个意义上,DIA追求的是原作品的“理想”版本,一种不受历史上意外影响的版本。书志研究的早期形式就是寻求重建一个著作的理想版本,以重现作者的原意。DIA也像这样,尝试将文档归一化、理想化,如此便可以使众多原本异质的文档彼此相通。正如整理不同的版本以得到权威的、理想的文本那样,归一化步骤去除了历史生产中的偶然因素——无论是在原本的印刷过程中产生的,还是在之后的数字化过程中产生的——以恢复“原始”文档及其“真正的”特征。它去除了历史记录的部分内容,即文本的复制史,以达到对历史记录(在这种情况下,就是对文本的生产史)更广泛的理解。

当然,意外产生的痕迹和有意为之的痕迹之间的区分,已经在书籍史和书志学中受到了很多批评。自D.F.麦肯齐(D. F. McKenzie)和杰罗姆·麦甘(Jerome McGann)等的著作之后,书志学的社会学转向就已经不再那么关注对原意和理想版本的重建,而更多关注的是去说明多种版本的特点及它们获得其意义的不同历史语境[21]对更多的文档进行解释,这可能是计算方法根本的优势。DIA在尝试对更多的文档进行解释的过程中,也遵循这一社会学传统,不去把文本的不同版本还原成单一的表征。这使得我们能够接受大量文档之间的差异和区别,进而更好地理解其传播的社会背景。其次,在DIA中,有关“前景”(foreground)和“背景”(background)的特征,它们之间的区别并非本质性的。换句话说,一位DIA研究者认为是背景的东西,比如倾斜的图像、扫描缩微胶片时的灰尘带来的失真、印刷过程中的不平直,另一位则可能把它们作为前景。归一化过程的基本范畴,是由研究者规定的,而非由先在的标准确定的。倾斜的普遍性和复制的特质能告诉我们数字化过程本身的一些东西,也有很多就像瑞恩·科德尔所说的那样,我们应该把OCR看作机器排版的一种形式。[22]DIA能够进行一种局部的理想化以将文档归一化,进而可进行大规模的比较。除此之外,它还有一种认识论上的灵活性,这也是它最大的优势之一。在这个意义上,DIA可以被视为书籍史学家的理想工具,可以用于描述和理解构成任何特定数字文档的技术中介的不同层次。

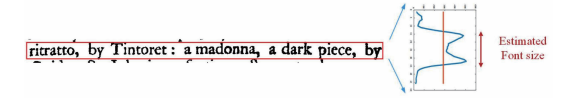

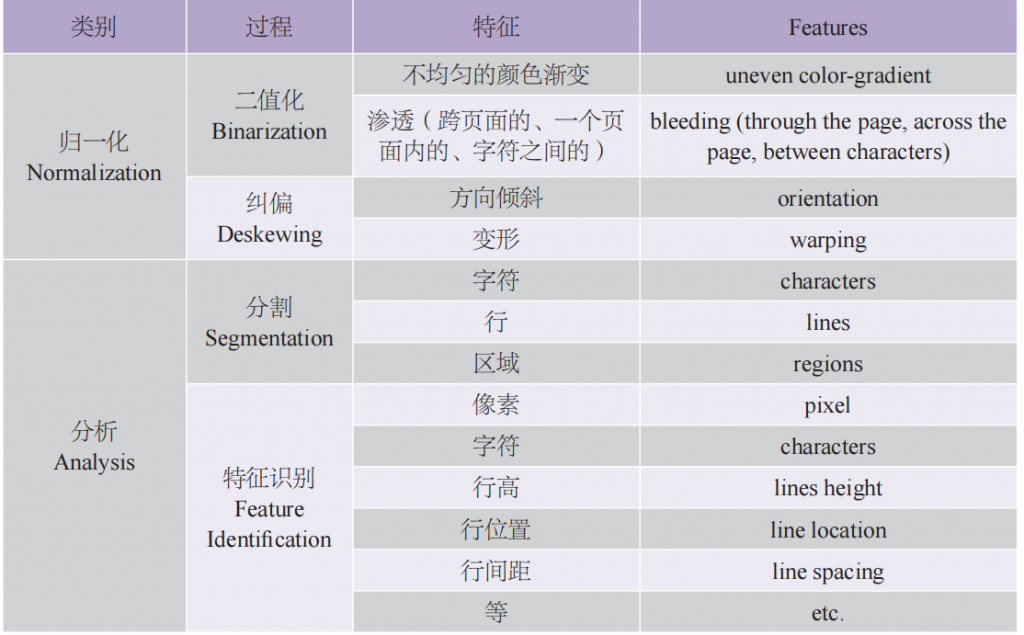

我们将DIA分析中使用的第二套程序步骤标示出来。这一步与书籍史领域中最近的解释学工作联系更明显(摘要见表2)。一旦页面被“归一化”,那么研究者就会对感兴趣的一些具体特征进行分析。分析过程的第一步多是分割(segmentation)。分割假设了有多种特质属于页面图像,而这些特质具有几何的或者区域的属性。当研究者只关注光学字符识别时,页面的基本分割区域(segments)就是字符和行。这些都可以使用上面讨论的“连通区域”(见图4)和“水平投影”(见图5)的方法进行识别。连通区域就是在黑色像素流之中没有断点的连续图形。理论上,这可以捕捉到单个字母。不过,在实践中,特别是在历史文档和不完美的图像扫描件中,这种方法可能会出现错误。行则会被估计为黑色像素最密集的范围,而根据投影直方图上的范围,就可以分割出不同行(见图5)。不过,一个分割区域也可能被当作页面的插图维度(illustrative dimension),比如当一个页面上端带有装饰性的图案或者狭义的插图时。就这一点而言,DIA使研究者能够识别并关注装饰或者插图传统。这些与我们之前所提及的书籍史的艺术史脉络非常一致。

来源:“十八世纪作品在线”(Eighteen-Century Collections Online)

但是,随着DIA的发展,研究人员越来越多地通过关注分割不同的视觉区域或者他们所谓的“视图”(view),来尝试解释页面的视觉异质性。字符和行成为了一个更大的可能的页面分割区域的一部分。根据这个理论,页面图像不能仅仅通过单一的书志学公式得到完整的描述。每一个页面都需要多重的可能视点。正如安德里亚·登格尔(Andreas Dengel)和法伊萨尔·沙法伊(Faisal Shafait)所认为的那样,为了获得“复杂文档的结构”,研究人员研发了通用模型:

这种通用模型将文档表示为一组布局结构(layout structures)或者几何结构。一组布局结构是视图(view)的一个集合,于是每一个视图都代表了对该文档的一个不同的布局解释。每一个布局结构本身就是一组几何形式的文档对象及这些对象之间的一组几何关系。[23]

图5 使用水平投影对行进行分割的估计,其结果为边界框将一行与其他行分割开。

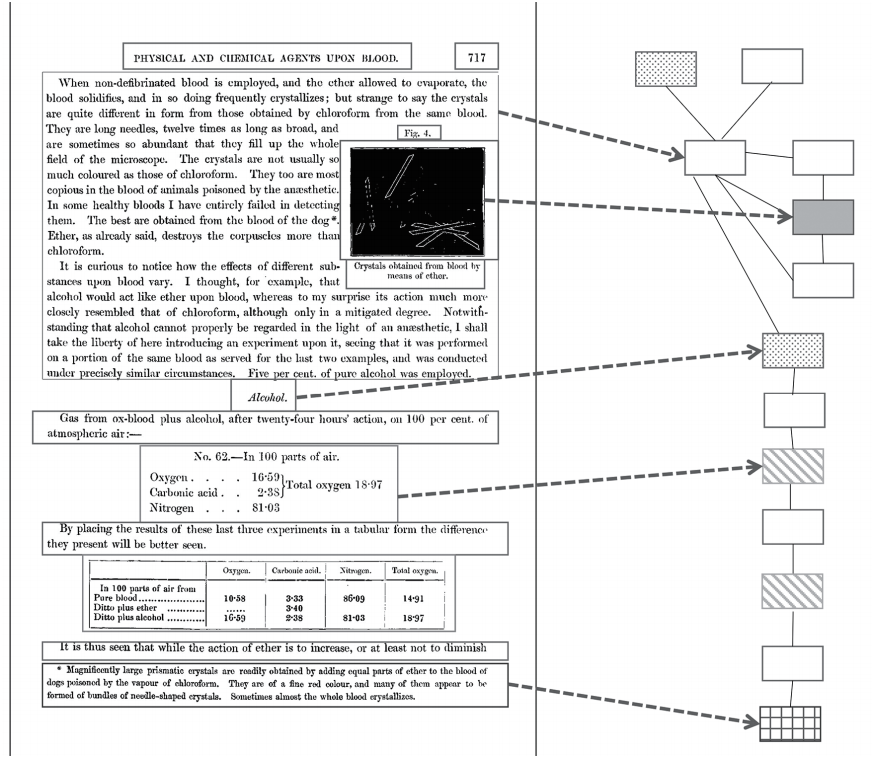

多个视图之间的这些关系和它们的类型识别(页眉、页脚、插图、装饰字母、留白、边框等)可以通过图的结构进行推断,从而实现了页面及其构成部分的灵活分类(见图6)。单个页面的布局结构具有多重的视图,这使得研究人员可以根据多种假设或者“表达”(representations)对文档进行标注。[24]对于DIA研究者来说,页面图像不是由整体的、单一的单元组成,而是为多重的可能视点搭建了框架。它使得任何给定的页面都可以具有阐释或者解释关系;正是页面图像的概念本身预设了书志学对象的符号过剩(semiotic excess)。用这种方法,DIA就直接继承了书籍史领域的阐释视角主义(the hermeneutic perspectivalism)。阐释视角主义在书籍史领域有着很长的历史。它假定了一种多义性,而至少自19世纪晚期以来,这种多义性就一直是语文学方法和文学研究的核心。

一旦对页面进行了分割,研究人员就可以专注于识别和测量特征(features)。正如在任何解释模型中那样,特征可能是无限的。在一个特定的页面上,几乎任何东西都可以被作为一个特征。字符的高度或行高、连体字母的数量、页边距的宽度、插入说明部分的存在——这些都是DIA可以捕捉的特征。有些特征(比如字符高度,或者字号)比其他的(像“视觉装饰”或者“图片真实度”)更基本。而最基本的特征是像素。重要的是,特征还是嵌套的:像素被用于理解“行高”,而它也可能是识别“书名页”等高阶特征的一部分。特征的识别是研究过程的一个核心部分,这个过程不能脱离研究的具体问题。研究人员如何对一个页面进行“建模”,就决定了他们会“看见”什么。不存在单一的、通用的页面视图。

表2 DIA 理解视觉页面的步骤

正如这些例子希望说清的,DIA在过去三十年的发展过程中,采用了也改变了书籍史领域中一些核心的分析价值观念。不过,它对待这些价值观念的方式,不是将其作为稳定的分类法,而更多地是作为视具体情况而变化的与页面进行互动的框架。不管是“前景化”或页面“视图”的行为,还是对“特征空间”(feature space)的识别,DIA都不依赖于图书或者页面的静态本体。相反,研究人员对不同历史时期或文化空间中图书的社会功能、创新功能和认识论功能的信念,都被DIA编码到看见页面的过程中。在这一点上,它是与书志学和语文学传统的解释冲动是高度一致的。在以当前学科方法来理解书志学过去的实践的同时,DIA还可以凸显这些实践的一些具体的维度。计算并非“客观的”,因为研究人员可以使用计算方法去产生一个固定的、“准确的”页面表达并将其普遍化。在很多方面,DIA都标志着与创造书志学上更普遍的页面视觉维度分类法这一早期目标分道扬镳。比如,加斯凯尔的手册就是要创造这种更普遍的分类法。图书中图形化手段的运用是如何参与到产生意义和组织社会互动这种更大的社会过程中的?加斯凯尔体系对装饰性的重视——比如,对字体、花饰斜体字母、页面平直和页面上部件的关注——只是思考这个问题的一个方法。[26]因此,要研究和思考图书更广阔的社会历史,当前用于看见页面的计算方法可以成为宝贵的工具。

二、脚注检测中不寻常的困难:一个案例研究

如果以上这些是文档图像分析借鉴书籍史和语文学的方法与实践来构建图书视觉模型的一些方法,那么在本节中,我们就将对核心分析步骤进行案例研究。这些步骤对于将这些方法运用于历史研究是必需的。我们如何利用这些技术来了解关于过去的一些情况?其中必不可少的步骤属于机器学习领域。要想对世界范围内的页面图像进行大规模的概括,机器学习需要一个过程来学习页面图像的表达。虽然有各种技术上的考虑(使用什么算法,如何训练它们等等),但是我们在此主要关注机器学习的非计算层面,目的同样是为了促进跨学科合作。我们要特别强调的是,当这些技术运用于对过去的研究时,书籍史学家的专业知识和方法技术是如何成为计算方法的必要补充的。

为了实现本文的目的,我们将关注脚注检测(detecting footnotes)这一案例。我们认为科学传播中运用的重要图形化手段有四个基本的视觉特征,而脚注正是其中之一(另外三个是表格、图表和参考图表)。在我们的大项目中,使用了两个重要的数据集:第一个由论文集组成,这些论文集来自5个不同国家(法国、德国、英国、瑞典和俄罗斯)的自然科学院,时间自1665年到1946年,共有828卷,512,516页;第二个来自“十八世纪作品在线”数据库(Eighteenth-Century Collections Online,简称ECCO),包括3,200多万页。这两者加在一起可以使我们既能够研究在不同国家背景下单一的科学文体中,页面图像的历时演变情况,也能够限制在一个关键时期和国别背景内,研究在更复杂多样的话语环境中页面的共时性关系。

为了进行分析,我们提出按下面四个基本步骤来实施历史文档的大规模研究:

1.定义

2.标注

3.特征识别

4.验证

为了大规模地检测一个视觉特征(在这个案例中就是脚注),我们需要对研究对象下一个工作定义。为了达到目的,我们是以下列方式定义脚注的:

脚注需得是位于页面底部(脚)的、有明显区别的、有标记的文本,而且这些文本还要在文本的正文部分被提到。

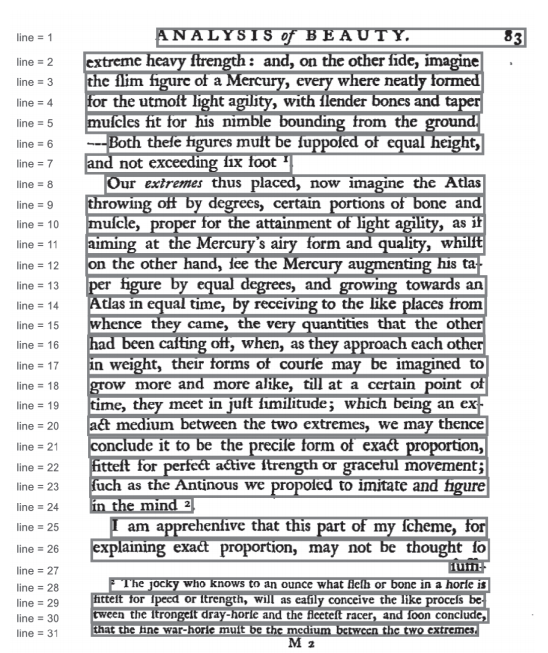

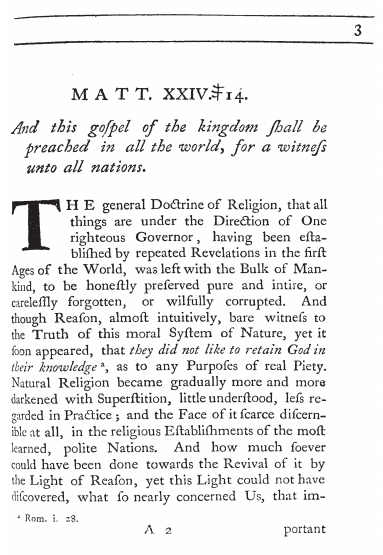

无论这样的定义看起来多么清晰明了,但是一旦用于大规模的历史文档,我们就会发现许许多多页面的例子给我们的分析带来了挑战。例如,1739年英国布里斯托的约瑟夫主教的《给国外传福音联合会的布道》[27]中的这一页(见图7)。在这个页面底部,有三个分开的文本分割区域。虽然它们之中只有(左边的)一个带有与正文相匹配的脚注标记(在斜体字“knowledge”后面),但是我们可以看到,在注释部分和正文部分中,脚注标记都极小且不规则。人类的视觉和训练使我们能够区分一个记号是“噪音”(或用我们上面的术语,是意外产生的),还是有意义的(或有意为之的)。但是,在图像分辨率很低的情况下,考虑到这个符号可能被解释成的所有混杂的关联之物:我们如何能够把脚注中的这个标记跟正文中标记的那个关联起来?我们如何才能把意外产生的污迹和这一小组像素区分开?而在正文中,脚注标记与撇号、瑕玷或者引号又有何不同?

关于大规模历史研究中定义和一般化出现的问题,这些只是一小部分。只要想象一下一个年轻人要正确地识别这个页面上的脚注所需的学习量,我们就能直观地感受到机器面临的挑战,以及要逐渐构建起对概念的理解所需例子的多样性,即便是简单到“脚注”这样的概念。亚德里安·约翰斯说,“印刷文化的发明,就是互动和想象的习惯的逐步发展,而这种习惯是独特的、通过训练形成的”。[28]这成为了我们研究过程中的一个直接挑战。正如我们在下一步中将要讨论的,我们必须向青年学生研究伙伴传输这样的与印刷品相关的假设和习惯。对我们而言,这些假设和习惯是来之不易的,而现在基本上又被视为理所当然的,故而从不需要有意识地去阐明。但是,大规模的历史研究则需要高水平的反思性的阐释:即使是我们的学术实践中最普通的假设和行为,也需要阐明和澄清。[29]

来源:“十八世纪作品在线”(Eighteen-Century Collections Online)

定义的挑战和共享性把我们带入处理过程的第二个步骤:标注(annotation)。在定义了我们感兴趣的视觉特征之后,我们就需要检查尽可能多的页面,标注它们是否有脚注,这样机器就可以最终学会正确识别脚注。正如上述挑战所表明的,并非所有的情况都很简单明了。机器的判断取决于处理过程中的师生给其的训练,以及裁决模糊情况的机制。在这一步骤中,我们人工标注了22,056个页面来训练机器(其中6,042个页面有脚注,16,014个页面没有),又人工标注了5,520个页面用于测试(其中554个页面有脚注,4,966个页面没有)。请注意我们使用的有脚注和无脚注的页面数量是不均等的,这样做是为了反映我们采集的文档中脚注的预期普遍性。这对于避免所谓的过拟合的问题很重要。过拟合会导致模型在运用于更大(或者多样的)文档集合时,适用性比较差。但是,不管我们用这种方法标记了多少文档,都是整个文档集合的一小部分。我们并不能确定,经过我们加标注步骤再扩展到整个文档集合以后,模型就是可靠的。正因为如此,我们需要最后一个步骤:验证(validation)。对这一步骤来说,重要的是,供机器学习用的底层表达要基于一种社会共识,而这个社会共识是由偶然的研究人员群体产生的。这是一个社会过程的结果。这样做的好处是反映了做大规模分析的目的,这一目的是识别独立于单个研究者观点的范畴。定义脚注,其背后的意图是以其他人也会同意的方式来框定这个概念。而加标注的做法正好检验了这个假设。这是否是一个可以取得高度人际认同的定义?尽管我们没有把这一问题纳入我们的研究过程,但是一个关键步骤是通过被称为“评判者间信度”(inter-rate reliability)的方法来检验这种共识的程度。这能够使研究者得以反思定义在不同类型的读者或学者间的共享性。

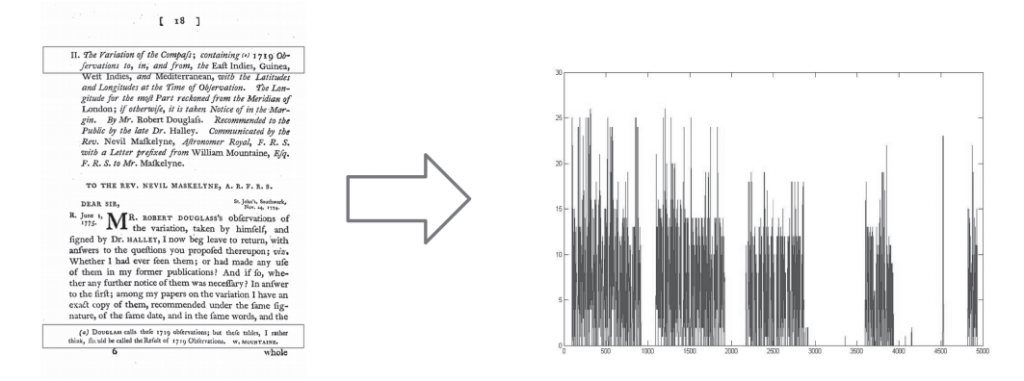

第三步是最具创新性的:我们尝试识别对脚注检测有帮助的特征。脚注可以被视为由较小的特征嵌套层构成的元特征。例如,我们使用的一个方法是测量行与空白之间的关系,以此识别脚注的位置和存在(见图8)。另一个方法是将行高投射为垂直直方图,以此来捕捉注释与正文字体大小不同的可能性(见图9)。[30]最后,用另一个方法将页面图像降采样为更小的像素集合,以产生模糊的图像,而将该图像当作黑白像素的单矢量(见图10)。[31]对所有这些情况来说,重要的都是这一事实,即在我们构建页面图像之前,并不存在中性的页面图像。我们感兴趣的视觉单元是如何对我们发生作用的,我们关于这一点的设想、信念和假设,都被构建到了页面视图(views)之中。我们捕捉的(和不捕捉的)脚注的类型完全取决于我们如何“看待”(view)页面,以及我们选择关注脚注的哪些方面。例如,我们关注行高,这就意味着,很多被忽略的脚注的相似之处是,相对于正文,它们都并没有改变字号。这是一个关键的方面,对特征的建模决定了你的方法将检测到的例子的类型。

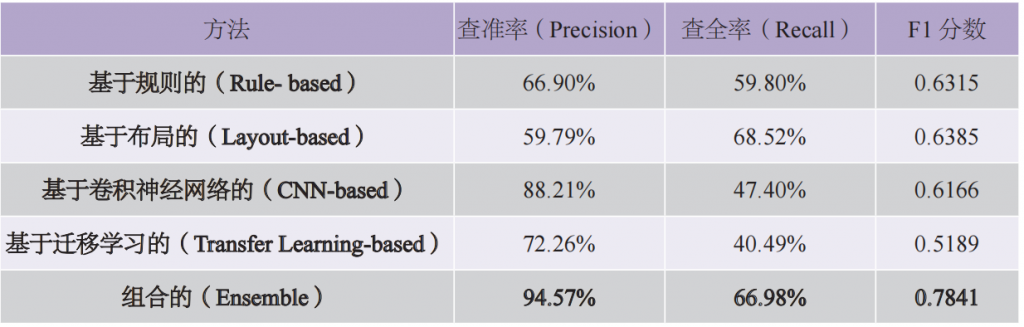

最后一个步骤是验证。选择哪一个算法是工程团队的事。机器学习算法使用这些特征表达来捕捉我们的标记,究竟每一个具体的算法完成效果如何呢?[32]表3展示了使用不同算法的结果以及它们组合的结果。

表3 使用四种不同的机器学习方法和组合方法进行分类处理的结果

这个表格告诉我们,当我们使用这四种算法的组合把一个页面识别为包含有脚注的时候,我们差不多95%是“正确的”。这是“查准率”这一列告诉我们的。“查全率”测量的是在被标记有脚注的页面中,有多大比例被机器预测为有脚注。在此,我们看到的数字就低得多。这意味着在我们测试的集合中,只捕捉到了标记为有脚注的页面总数的67%。这样的话,大约三分之一的有脚注页面没有被检测出。但是,凡是我们检测到的,还是非常准确的。这是一个典型的查准率/查全率利弊权衡。在这一方面,最广为人知的例子就是机场安检问题,不过,机场安检是出于相反的动力(查全率非常高,也即很多人因为被怀疑携带武器而被拉到一边,但是查准率比较低,也即有很多假阳性,很多被怀疑的人并非真的携带了武器)。

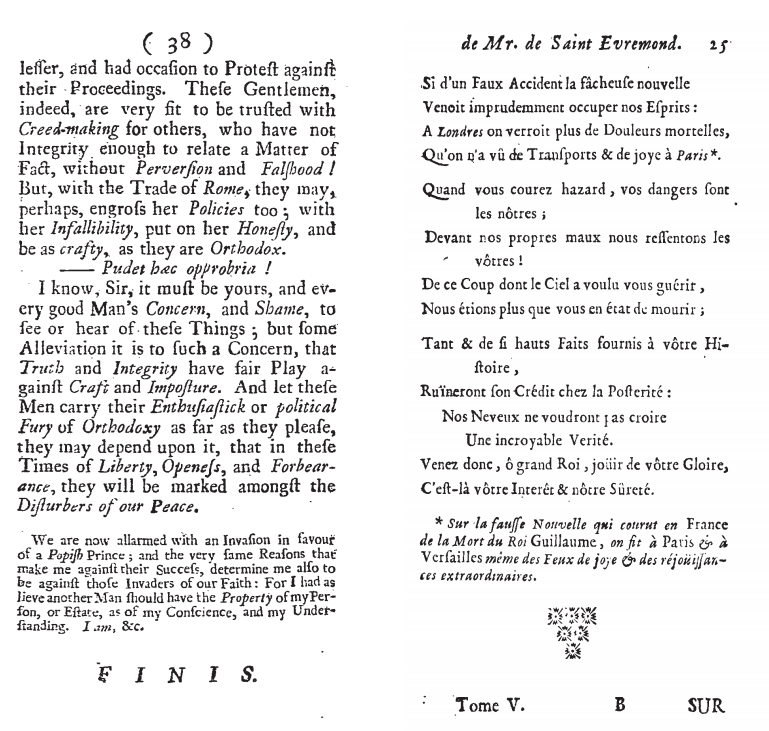

而比这个数值表更重要的是对结果的定性检查,这是表格生成后必须进行的。哪些种类的页面被错误地识别为带有脚注,而哪些有脚注的又错误地被漏掉了?在此,我们举一个“假阳性”(被预测为有脚注的页面,实际并没有脚注)和一个“假阴性”(有脚注的页面没有被预测出)(见图11)。比如在左边的页面图像上,我们可以看到,在页面的底部,文本有一个不同的部分,其与上面的文本是分开的,而且使用了较小的字体。但是,它缺少指涉文本正文的脚注标记。因为脚注标记的存在太难检测出来了,所以在总数不多的假阳性中,很多都存在这个特点。而在右边页面图像上,我们可以看到通篇排字都不规则,这使得脚注也不突出。而且脚注下面还有一些字和装饰图案,这也掩盖了它的“页脚属性”(footness),也就是它其实是位于页面底部的。在很多其他例子中,页脚文本与正文文本之间的相似性,似乎都是页脚可能未被检测出来的核心特点。

理解错误是研究过程的关键组成部分,这通常可能有助于设计出更好的检测特征。但是,我们如何归纳错误,也是有局限的。而实践的多变性加上与训练数据的局限(如何识别出一条规则的所有可能例外),意味着不确定性与错误将内在地成为分析过程的一部分。这是对历史的研究中一个关键的新维度,需要我们在前进过程中进一步反思。

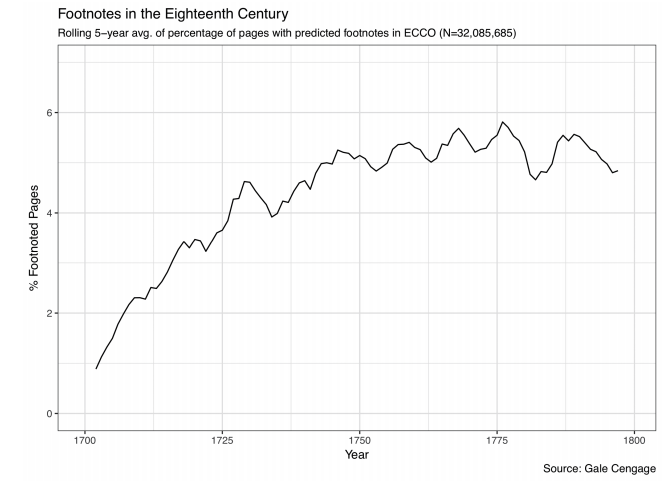

三、脚注的历史

那么,从这一切中我们能学到什么呢?一旦能够大规模地检测脚注,我们将能够讲述关于印刷、传播和知识的什么样的新历史?正如在图12中所见,整个18世纪,从整个文化普遍的角度来看,在英国印刷的文本中,脚注都实现了一种常规化。而这种常规化是很有趣的。直到18世纪中期(一个统计模型显示,1745年是转折点),脚注的使用一直遵循着一个高度可预测的线性增长路径。然后,它就趋平了,形成了一个相对稳定的共识,即在所有印刷页面中大约5.2%设有脚注。而这是我们以前没有看到的:大的文化行为遵循着先增长而后达到共识的生产模式。无论局部的年度差异怎样,随着时间的推移,具体到这种图形化手段的运用时,所呈现出的规律性程度都令人惊讶。

这些发现也开启了一系列需要进一步研究的问题:为什么脚注的普及率稳定在5%左右,为什么有那些波动?在标题中有没有语义标记与页面中脚注概率的增加相关吗?文本的语言与其视觉特征之间,有没有可辨识的关系?关于18世纪欧洲知识的形态,这类问题能告诉我们什么,这是我们感兴趣的。很快,这些更正式的问题就引出了更广泛的关于知识史的问题。是什么推动了18世纪上半叶脚注使用的兴起?正如安东尼·格拉夫顿(Anthony Grafton)所言,在历史学科中,脚注的兴起应该被视为有别于中世纪和现代早期的书籍评注实践。[33]18世纪上半叶脚注日益盛行,这是如何与以下论点相合的,即这一时期“博学帝国”(empire of erudition)开始分化成为更多不同的知识领域,比如期刊报道的“消息”,不再仅仅是来自文学界的了,而是来自分化程度越来越高的不同学术传播领域?[34]更好地理解脚注(以及表格、图表、参考图表和其他图形化特的答案,不过,视觉数据可以帮我们找到解释框架,通过这些框架我们可以更好地从大规模的角度理解历史上的传播实践。

ECCO 中预测有脚注的页面百分比五年平均值变化情况(N=32,085,685)

纵坐标:有脚注的页面 / %

横坐标:年份

图12 “十八世纪作品在线”数据库中每年有脚注的页面数量的预测平均值

来源:Gale Cengage

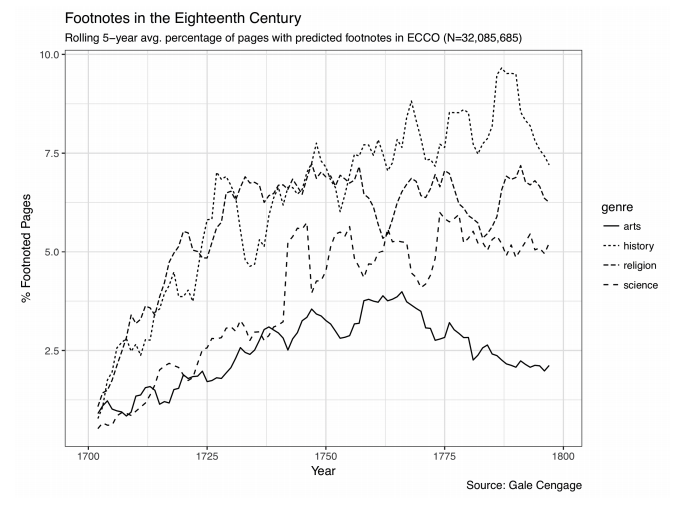

我们还可以进一步在数据中挖掘,看看不同的写作类别或者领域在脚注方面是否表现不同。尽管要黑白分明地体现出来有些难,但是我们还是可以看到,整个18世纪历史写作在使用脚注方面明显处于领先地位(见图13)。正如格拉夫顿等学者早已论述的,直到19世纪初,相比于科学写作(我们这四个类别中从高到低排第三的),历史写作都更强有力地推动了书籍间的引用。[35]我们还可以看到,文艺类(Arts)如何显著地减少了引文的使用,从而与众不同。考虑到18世纪上半叶更可能使用脚注的书籍的语文学指标都是与“纯文学”(belles lettres)、修辞和经典语文学相关的,这种减少趋势特别值得注意。[36]在创作性写作方面,18世纪的意识形态转变很有意思——原本其为书籍间引用的驱动者,到后来愈发缺少这种引用却成了其特征。文学阅读从一种高度以学术视角传达的实践,转变为旨在成为有沉浸感的、切身的阅读实践。但是根据我们的研究结果,这种转变发生的时间远比传统上所确定的要早。

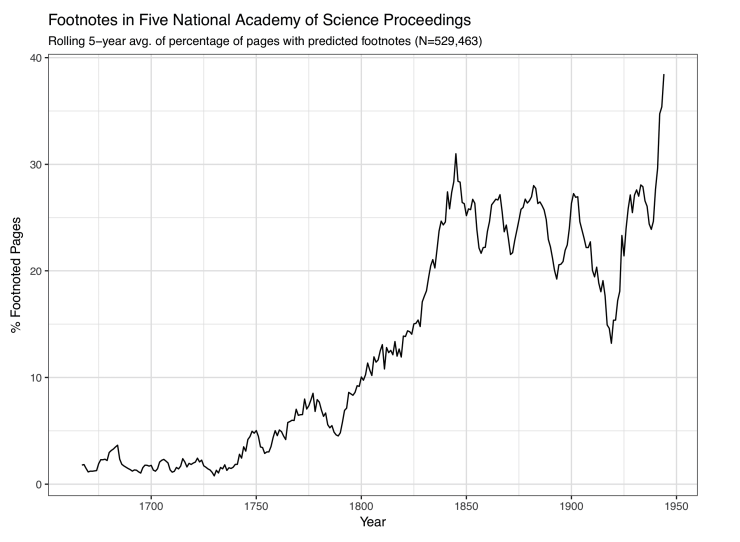

最后,我们再看看另一组数据,即五个欧洲国家科学院院刊论文集(见图14)。从中我们可以看到,1800年以后,引用实践的第二波大浪潮是如何定义科学写作的。我们在18世纪所见到的不同类别写作的一致情况,在19世纪被科学传播这个特别的领域远远抛在了后面。在此,关键的时期似乎是19世纪上半叶,尤其是1825至1850年期间。尽管我们没有这一时期历史写作的数据,但是我们猜测科学的引用实践会远超历史类,这表明了学科格局进入了一个新时期。如果科学院院刊论文集中脚注页面的猛增,与科学史学家阿里克斯·齐萨(Alex Csiszar)最近所说的1830年代“期刊闯入了精英科学机构”之间,存在着某种关系的话,那么这种关系是什么?[37]学院决定出版院刊期刊,而不是像《哲学汇刊》(Philosophical Transactions)这样“重量级”(weighty)且并不严格具有周期性的大部头出版物,这是否也带来了不同的印刷和阅读实践以及不同的树立知识权威的方式?这些仅仅是印刷和科学传播的视觉史所能带来的初步见解和问题中的一部分,而更多的仍可期待。

ECCO 中预测有脚注的页面百分比五年平均值变化情况(N=32,085,685)

纵坐标:有脚注的页面 / %

横坐标:年份

右侧图注:类别(自上而下依次为:文艺、历史、宗教、科学)

图13 18 世纪不同类别的文档页面有脚注比例的预测值

来源:Gale Cengage

预测有脚注的页面百分比五年平均值变化情况(N=529,463)

纵坐标:有脚注的页面 / %

横坐标:年份

图14 五国国家科学院院刊论文集中有脚注页面的百分比预测值

结 论

在这篇文章中,我们尝试解释了页面图像能够作为历史研究对象的计算条件和认识论条件,以及关于这种知识可能为历史学家带来的一些初步的见解。我们的主要目的,并非只关注个别的发现,而是要澄清这些发现得以实现的条件。我们的目标之一是向书籍史学家同行介绍一种用以理解文档的相对新的方法和技术——DIA,也要向计算机科学家和DIA研究人员介绍长期以来在历史文本研究中业已成熟的学术实践和规范。正如上文所概括的,尽管DIA和书籍史处理文本的方法有显著的不同,但也有重要的连续性。正如我们所表明的,DIA在各种步骤中常常隐含着基本的书籍史和书志学的见解。它继承了一些假设、分类、见解和理念,而简单化地将计算方法或学术研究与人文方法对立起来,则会掩盖这些假设、分类、见解和理念。总之,我们想要思考,在档案条件发生变化的情况下,我们所强调的DIA跟书籍史、书志学之间的联系与区别,如何能够使关于历史文档研究的一些核心方法论问题成为关注焦点。[38]

1.程序性知识

DIA是一种高度程序性的知识形式。它包括一系列分析步骤,这些步骤通常是以一种线性方式进行的。把它们比作工作流程或者流水线,这在计算研究中比比皆是。我们在此概述的所有步骤——归一化、分割、特征选择、训练、预测和检验,都是按顺序执行的,并通向对大量历史文档的视觉特征的综观性理解。尽管这看似不同于学者们过去的档案工作实践——对外行人来说(甚至有时对内行人来说也是),这种实践的发现过程,可能看起来或者感觉是很随意的——但是,其实人工检索档案同样是以一种理论框架组织起来的,这种理论框架支配了浏览档案库的路径和选择,但这个档案库是无法得以整体把握的。我们认为,DIA的不同之处就在于,这些路径每一步都被(或者应该被)明确了。与档案库中的学者不同,DIA研究团队想要他们的行为是完全可复制的。在这个意义上,程序主义可以是可见性的一种有力形式。

2.转换性知识

DIA本质上是一种高度转换性的知识。[39]从二值化到特征选择再到机器学习,在每一个阶段中,我们都在为底层页面图像产生新的表达,以便更好地大规模地理解它们。在某种意义上,这种工作与历史文档再生产的编辑劳动是非常一致的。在这种传统中,认真仔细地、深思熟虑地进行这种转换实践对这一领域是至关重要的。[40]另一方面,这种转换性的原则也标志着,其与麦肯齐及他的追随者所使用的依靠文本细节的方法有很大的不同。在他们的方法中,研究的目标就是尽量恢复原始文档的历史细节。但是,在这两个案例中,终极目标都是更好地了解过去的社会实践。关于过去有新的表达被创造出来、原始资料得到综合的契机,就是对过去进行概括的契机。正如建构一些关键版本以解释对最终表征有贡献的各种不同的证据,DIA强调的是使用中介来理解历史中介过程。

3.偶然性知识

过去十年来,学者和广大公众对“大数据”的热捧,很大程度上是由社交媒体或者相关互联网平台产生的结构相对完善的数据爆炸性增长所驱动的。但是,我们研究过去的能力却取决于我们能得到的材料,以及学者利用这些材料的形式、媒介和组织。就像所有计算方法一样,DIA取决于哪些文档已经被数字化以及这些文档被组织得如何。历史学家和书志学家把这些约束和偶然事件作为尝试对过去进行研究的既定条件,所以他们发展出了处理这些档案和文本材料中偶然事件的实践和方法。对过去的计算研究和对大规模数据的依赖,并不意味着我们就能撇下对包容性和代表性的这些考虑。如果它们意味着什么,那就是随着我们尝试基于数据集来概括过去的实践,这些问题将变得愈加迫切。因为这些数据集庞大的规模太容易使我们看不到被排除在其外的事物、其中的间隙和遗漏。

4.知识与错误

书志学家、语文学家和历史学家一直都在思考关于“错误”(error)的问题,无论是从文本“腐败”(corruptions)(这是本来理想的表达被歪曲的来源)的角度,还是从另一个评论者对过去进行了错误的推论这个角度。不过,传统上处理文本的学者一直在寻求去除或者改正这些“错误”,而像DIA这样的计算方法则将错误作为构成其所生产的知识的一个基本特征。这是一个关键区别。作为知识的一种有条件的形式,DIA将不确定性的大小作为推论过程的一部分。在产生相当于一个具体页面的模型的东西时,DIA就说明了它所要尝试测量的东西及其测量成功的限度。例如,DIA并不仅仅做出关于脚注是否存在的明确的范畴判断(如“有脚注”或“无脚注”),它还提供概率估计(例如,这个算法有68%或者92%的概率确定该页面上有脚注)。而这些概率如何与对过去的文档的解释性判断相关,这就打开了另一条新的研究通道。关于不同的技术、档案和算法,我们可以开始讲述什么样的具有推论不确定性的历史?过程中的不确定性的水平如何影响我们可能建构的这种历史叙述?当涉及到计算建模时,错误和论证之间的关系又是什么?

正如我们试图表明的,DIA是历史研究的一种宝贵工具。以前人工进行大规模文档档案整理的时候,根本不可能发现的历史现象,DIA能帮助我们发现。通过吸收书籍史学家和书志学家的很多原则和信念,DIA把重要的证据形式插入到对过去的计算研究中去了。同时,DIA还为历史解释引入了具有挑战性的新认识论条件。那么,我们该怎么看待在机器学习的过程中文档证据经历的多重转变,这该会如何影响我们对过去的理解呢?再说到数据,这些多样的而根本上又是偶然的观点,指引着加标注和验证过程,我们如何吸纳它们呢?最后,我们如何围绕不确定性和错误等概念来构建历史叙述,而不是让所构建的历史叙述仅仅是这些概念的替代物呢?这些只是DIA带给历史研究的一部分问题。作为一个前进的共同体,我们希望来回答这些问题。

—————————————————————————————————————————————————————————————————

The Page Image: Towards a Visual History of Digital Documents

Andrew Piper, Chad Wellmon, Mohamed Cheriet

Abstract:

“Document Image Analysis” (DIA) is a procedural, transformative and contingent form of knowledge, which also possesses the probability of error intrinsically. In the study of historical archives, this approach draws on the traditions of book history and bibliography, as well as a theory of inter-mediality. It moves away from a text-centric understanding of the page and takes the whole “page image” as the object of its analyses. It does not aim to build an ideal version of the original anymore, but to understand the past social practices better through constructing and analyzing new representations of the page. In practice, DIA has developed a set of procedural methods, including normalization, segmentation, feature selection, machine training, prediction and validation, so as to analyze the different visual features of the pages. This article applies these methods to the analysis of the prevalence of footnotes in four domains of writing in 18th century, which are arts, history, religion and science, and to the proceedings of five European national academies of science in the 18th-19th centuries, showing a new period of disciplinary configuration. This suggests that “Document Image Analysis” is a valuable tool for historical research.

Keywords: Page Image; Document Image Analysis; Book History; Bibliography; History of Knowledge

———————————————————————————————————————————————————————————————————

编 辑 | 姜文涛

原文信息如下:

Andrew Piper, Chad Wellmon, and Mohamed Cheriet, “The Page Image: Towards a Visual History of Digital Documents,”Book History, vol. 23, 2020, pp. 365-397, published by Johns Hopkins University Press, DOI:

https://doi.org/10.1353/bh.2020.0010.

感谢作者、译者和美国霍普金斯大学出版社授予中文版权。

注释:

[1]参见Proceedings of the First International Conference on Document Analysis and Recognition (ICDAR 1991)。第一次关于文档图像分析大会的论文集竟然从没有数字化,也没有被分析。在文档数字化的奇特世界中,这倒并不令人惊讶。

[2]George Nagy, “Twenty Years of Document Image Analysis in PAMI,”IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 22, no. 1, 2000, pp. 38-62.

[3]Ryan Cordell, “Q i-jtb the Raven: Taking Dirty OCR Seriously,”Book History, vol. 20, 2017, pp. 188-225.

[4]Matthew Kirschenbaum, Mechanisms: New Media and the Forensic Imagination, Cambridge: MIT Press, 2008.

[5]Andrew Piper, “Deleafing: The History and Future of Losing Print,”Gramma, Special Issue on “The History and Future of the Nineteenth-Century Book,” eds. Maria Schoina and Andrew Stauffer, vol. 21, 2013.

[6]Chirstoph Windgätter, Medienwechsel. Vom Nutzen und Nachteil der Sprache für die Schrift, Berlin: Kadmos, 2006. Also see Carlos Spoerhase, Linie, Fläche, Raum: Die Drei Dimensionen des Buches in der Diskussion der Gegenwart und der Moderne, Göttingen: Wallstein, 2016.

[7]Garrett Stewart, The Look of Reading: Book, Painting, Text, Chicago: University of Chicago Press, 2006.

[8]Walter Ong, Orality and Literacy: The Technologizing of the Word, London; New York: Methuen, 1982; Sybille Krämer, Schriftbildlichkeit: Wahrnehmbarkeit, Materialtät and Operativität von Notationen, Berlin: Akademie Verlag, 2012; Sybille Krämer, “Zwischen Anschauung und Denken: Zur Epistemologischen Bedeutung des Graphismus,”Was Sich Nicht Sagen Lässt, eds. Joachim Bromand and Guido Kreis, Berlin: Akadamie Verlag, 2010. 克莱默的著作试图重新思考那些对与口述和字母化密切相关的书写的经典描述。

[9]Mara Mills, “Print Disability. Die Ko-Konstruktion von Blindheit und Lesen,”Disability Trouble, ed. Ulrike Bergermann, Berlin: B_books, 2013, pp. 195-204.

[10]Mark Changizi, The Vision Revolution: How the Latest Research Overturns Everything We Thought We Knew About Human Vision, Dallas: BenBella Books, 2009; Stanislas Dehaene, Reading in the Brain: The New Science of How We Read, New York: Penguin, 2009.

[11]Paul Fyfe, Qian Ge, “Image Analytics and the Nineteenth-Century Illustrated Newspaper,”Journal of Cultural Analytics, October 24, 2018, DOI: 10.22148/16.026; Neal Audenaert, Natalie Houston, “VisualPage: Towards Large Scale Analysis of Nineteenth-Century Print Culture,” 2013 IEEE International Conference on Big Data, 2013, pp. 9-16.

[12]Adrian Johns, The Nature of the Book: Print and Knowledge in the Making, Chicago: University of Chicago Press, 2000; Elizabeth Eisenstein, The Printing Revolution in Early Modern Europe, Cambridge: Cambridge University Press, 1983; Ann Blair, Too Much to Know: Managing Scholarly Information before the Modern Age, New Haven: Yale University Press, 2011; Aileen Fyfe, Bernard Lightman, Science in the Marketplace: Nineteenth-Century Sites and Experiences, Chicago: University of Chicago Press, 2007.

[13]Bradley Pasanek, Chad Wellmon, “The Enlightenment Index,”The Eighteenth-Century Theory and Interpreation, vol. 56, no. 3, 2015, pp. 257-280; Anthony Grafton, The Footnote: A Curious History, Harvard: Harvard University Press, 1999.

[14]John Bender, Michael Marrinan, The Culture of the Diagram, Palo Alto: Stanford University Press, 2010.

[15]Lorraine Daston, Peter Galison, Objectivity, Cambridge: Zone, 2007; Barbara Maria Stafford, Artful Science: Enlightenment and Entertainment and the Eclipse of Visual Education, Cambridge: MIT Press, 1996.

[16]Lorraine Daston, Peter Galison, Objectivity, 2007.

[17]参见两本近期发表的特刊,它们在文学研究领域讨论了这一话题:Krishan Kumar, Herbert F. Tucker, “Writ Large,” Special Issue of New Literary History, vol. 48, no. 4, 2017; James English, Ted Underwood,“Scale and Value: New and Digital Approaches to Literary History,” Special Issue of MLQ ,vol.77, no. 3, 2016。

[18]Philip Gaskell, A New Introduction to Bibliography, New Castle: Oak Knoll, 1995, pp. 154-159.

[19]John Harthan, The History of the Illustrated Book: The Western Tradition, London: Thames and Hudson, 1981; Gordon Ray, The Illustrator and the Book in England from 1790 to 1914, Oxford: Oxford University Press, 1976; Arthur Rümann, Das Illustrierte Buch des XIX. Jahrhunderts in England, Frankreich und Deutschland, 1790-1860, Leipzig, 1930; Theodor Kutschmann, Geschichte der deutschen Illustration, vom ersten Auftreten des Formschnittes bis auf die Gegenwart, Berlin: F. Jäger, 1900.

[20]我们对DIA实践的评估是基于以下两本手册的,也强烈向对此领域感兴趣的读者推荐:Cheriet Mohamed et al., Character Recognition Systems, Hoboken: Wiley, 2007; David Doerman, Karl Tombre, Handbook of Document Image Processing and Recognition, London: Springer, 2014.

[21]D. F. McKenzie, Bibliography and the Sociology of Texts, Chicago: University of Chicago Press, 1999. 最近的研究请见《图书记忆》(Memoire du Livre)关于“文本历史”的专刊,这些原则在其中得到了实践。“Textual Histories,”Memoire du Livre, ed. Yuri Cowan, vol. 4, no. 2, 2013.

[22]Cordell, “Q i-jtb the Raven,” pp. 188-225.

[23]Andreas Dengel, Faisal Shafait, “Analysis of the Logical Layout of Documents,”Handbook of Document Image Processing and Recognition, eds. David Doermann and Karl Tombre, London: Springer, 2014, p. 188.

[24]Dengel, Shafait, “Analysis of the Logical Layout of Documents,” p. 188.

[25]Simone Marinai, “Page Similarity and Classification,”Handbook of Document Image Processing and Recognition, pp. 223-253.

[26]See The Multigraph Collective, Interacting with Print, Chicago: University Of Chicago Press, 2017.

[27]Joseph Lord Bishop of Bristol, A sermon preached before the Incorporated Society for the Propagation of the Gospel in Foreign Parts, 1739.

[28]Johns, The Nature of the Book, 2000.

[29]这是大规模历史研究的价值之一。成功的扩大规模,远非对个别对象或者文档的近距离、直接理解,它首先取决于缩小的程度。通过这种缩小,达到对研究对象最具体形式的深入理解。

[30]Mohamed Mhiri et al., “Footnote-based Document Image Classification Using 1D Convolutional Neural Networks and Histograms,” International Conference on Image Processing Theory, Tools, and Applications, 2017.

[31]Sherif Abuelwafa et al., “Feature Learning for Footnote-Based Document Image Classification,” International Conference on Image Analysis and Recognition, 2017, pp. 643–650, DOI: 10.1007/978–3– 319–59876–5_71.

[32]为了聚焦于本文的目标,我们略去了对项目中所使用的算法及其如何影响处理过程的详细讨论。更全面的讨论,请参见:Sherif Abuelwafa et al., “Detecting Footnotes in 32 Million Pages of ECCO,”Journal of Cultural Analytics, December 3, 2018, DOI: 10.31235/osf.io/7m8ue。

[33]Anthony Grafton, The Footnote: A Curious History, Harvard: Harvard University Press, 1999.

[34]Chad Wellmon, Organizing Enlightenment: Information Overload and the Invention of the Modern Research University, Baltimore: Johns Hopkins University Press, 2015, pp. 45-76.

[35]Anthony Grafton, The Footnote: A Curious History, Harvard: Harvard University Press, 1999.

[36]我们使用“g-检验”(g-test)这一信息理论方法来识别,在1700—1745年这个过渡时期,相比于一般图书,哪些词更可能出现于有大量脚注的图书书名中。

[37] Alex Csiszar, The Scientific Journal: Authorship and the Politics of Knowledge in the Nineteenth Century, Chicago: University of Chicago Press, 2018, p.6.

[38]关于在文化社会学中希望使用数据驱动和计算方法所面临的挑战方面,有助益的讨论参见:Christopher A. Bail, “The Cultural Environment: Measuring Culture with Big Data,”Theoretical Sociology, 2014, vol. 43, pp. 465-482。

[39]关于算法的转换性本质的讨论,参见:Benjamin M. Schmidt, “Do Digital Humanists Need to Understand Algorithms?,”Debates in Digital Humanities, vol. 48, 2016.

[40]See Darcy Cullen, Editors, Scholars, and the Social Text, Toronto: University of Toronto Press, 2012.

原刊《数字人文》2021年第3期,转载请联系授权。